I robot assassini sono un rischio serio. E se ne occuperà l'Onu

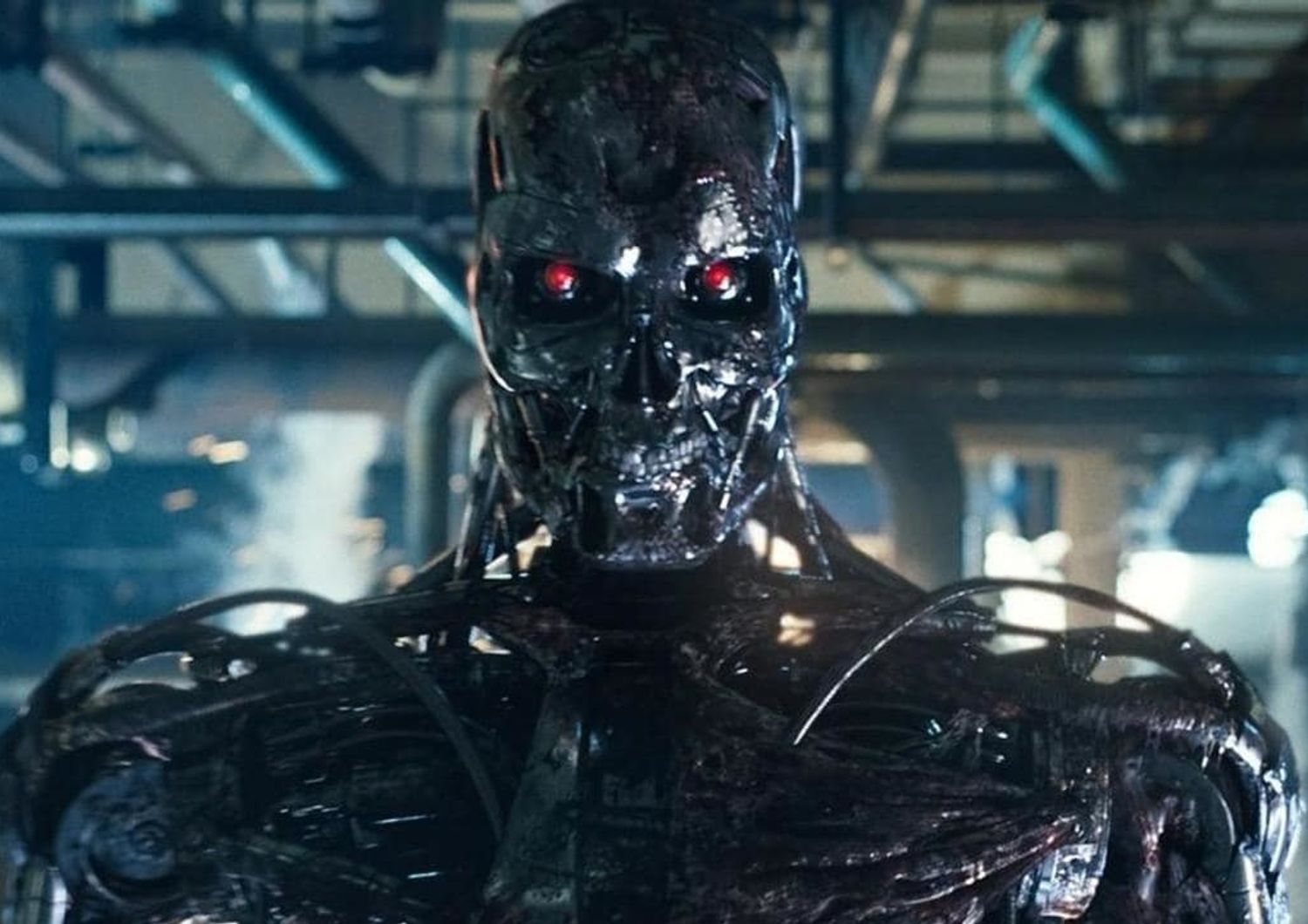

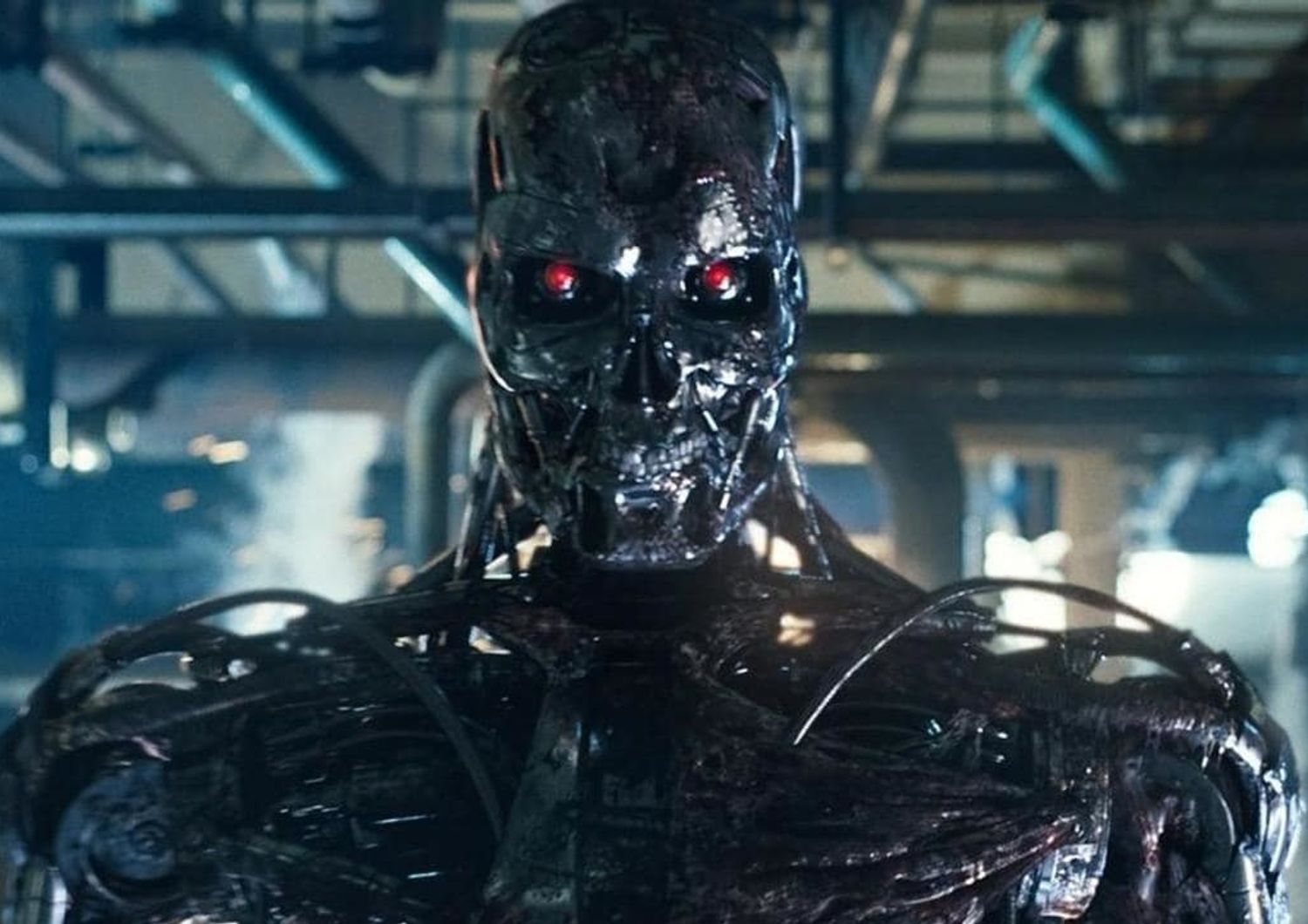

Che uno sviluppo incontrollato della robotica e dell'intelligenza artificiale possa mettere in pericolo la sopravvivenza dell'umanità non è una paranoia di chi ha visto troppi film di fantascienza. Moniti in questo senso sono stati lanciati da personalità del calibro di Stephen Hawking ed Elon Musk ed è tempo che la politica si faccia carico della questione. Soprattutto se si tiene presente che, come inevitabile, sarà l'industria della difesa a sfruttare alcune delle applicazioni più sofisticate di queste tecnologie, che da questa industria vedono arrivare gli investimenti più ingenti.

Già oggi l'automazione è sempre più sfruttata dagli eserciti, come dimostra il crescente utilizzo di droni da parte del Pentagono per effettuare bombardamenti o eliminazioni mirate in Iraq e in Afghanistan. Cosa succederebbe se macchine create per uccidere e dotate di intelligenza artificiale sfuggissero al controllo dei governi, finendo nelle mani dei terroristi o, ancora peggio, autodeterminandosi? Con le tecnologie già disponibili, si tratta di scenari tutt'altro che remoti, tanto da aver costretto un gruppo di scienziati a raccogliersi sotto l'ombrello della campagna "Stop Killer Robots" e porre il problema all'attenzione delle Nazioni Unite perché pongano un veto sui robot assassini analogo a quello attualmente in vigore per le armi chimiche. Secondo i promotori della campagna, alcune nazioni - tra le quali Usa, Cina, Russia, Regno Unito, Israele e Corea del Sud - stanno già elaborando sistemi che conferiranno alle macchine una "maggiore autonomia di combattimento". La prossima generazione di droni non avrà più quindi bisogno di fare riferimento a un operatore umano per compiere le proprie missioni di morte. Ovvero, si va verso macchine che potranno decidere da sole se uccidere o meno un uomo.

Già lo scorso agosto cento manager responsabili di alcune delle aziende più innovative in campo di robotica e intelligenza artificiale avevano sottoscritto una lettera aperta all'Onu per chiedere di impedire l'impiego di robot negli eserciti. Tra i firmatari Mustafa Suleyman, numero uno di Deep Mind, la divisione AI di Google, lo stesso Musk e tre italiani: Alessio Bonfietti di MindIT, Angelo Sudano di ICan Robotics e Domenico Talia di DtoK Labs. Appelli analoghi sono giunti da diciannove Paesi, tra i quali figurano - in maniera significativa - Egitto e Pakistan, che vogliono scongiurare a ogni costo la possibilità di vedere queste armi in mano ai jihadisti.

Uno dei cento firmatari, Stuart Russel, vicepresidente di Bayesian Logic e docente di Intelligenza Artificiale all'università di Berkeley, ha prodotto un cortometraggio, breve ma decisamente inquietante, che è stato mostrato oggi durante un'evento promosso dalla campagna presso la Convenzione delle Nazioni Unite sulle Armi Convenzionali. Il breve film mostra uno stormo di droni che - senza più il controllo dei supervisori originali - fa strage di umani con devastante efficienza.

"La tecnologia mostrata nel film è semplicemente un'integrazione di tecnologie già disponibili. Non è fantascienza. Anzi, è più semplice da raggiungere delle auto che si guidano da sole, che richiedono standard di performance ben più elevati. Perseguire lo sviluppo di armi autonome letali ridurrebbe drasticamente la sicurezza internazionale, nazionale, locale e personale". Questo genere di macchine, infatti, non ha costi di produzione eccessivi, e, con l'avvio di una produzione di massa, finirebbero facilmente in mano a organizzazioni terroristiche. Magari il principale dilemma posto dagli automi fosse comprendere se tassarli o meno.

"C'è una nuova corsa alle armi tra le nazioni più tecnologicamente avanzate per sviluppare sottomarini, aerei da combattimento, navi da guerra e carri armati autonomi che possano trovare il loro bersaglio da sole e usare forza bruta senza l'intervento di decisioni umane. Un solo grosso conflitto sarà sufficiente a scatenare queste nuove armi con tragiche conseguenze umanitarie e e una destabilizzazione della sicurezza globale", ha avvertito Noel Sharkey, professore emerito di intelligenza artificiale dell'università di Sheffield, "l'Onu si muove con la lentezza di un iceberg e interessi economici ostacolano ogni passo. Ma la campagna continua con un enorme sostegno della comunità scientifica. Dobbiamo riuscire perché le alternative sono troppo orribili".