Le novità che Google porterà nelle case (e sugli smartphone)

Doveva essere il giorno del Pixel 3A, lo smartphone economico di Google. Ed è arrivato. Ma nella conferenza I/O a rubare l'occhio sono alcune funzioni che arriveranno presto: accorgimenti sulla privacy (Maps in incognito) e un'assistente digitale che – se le dimostrazioni viste sul palco saranno confermate alla prova pratica – sembra davvero fare un salto notevole.

Lo smartphone economico di Google si chiama Pixel 3A. Ed è disponibile sia in versione standard (da 5,6 pollici) che in quella XL (da 6 pollici). Ampiamente anticipato dalle indiscrezioni, il 3A segue la tendenza di questo 2019: i grandi marchi, alle prese con un mercato asfittico, affiancano ai top di gamma dispositivi di fascia media. I nuovi Pixel tagliano parecchio il prezzo rispetto ai fratelli maggiori: 399 euro per il 3A e 479 euro il 3A XL.

La disponibilità è immediata anche in Italia. Il design è quello tipico dei Pixel, con una scocca, a due toni, disponibile in tre colori: nero, bianco e viola tenue. Batteria da 3700 mAh per il 3A XL e da 3000 mAh per il 3A. La promessa è di 30 ore con una singola ricarica e 7 ore con una ricarica rapida da 15 minuti. Salvo le dimensioni, i display sono identici per tecnologia (Oled) e definizione. Uguale è anche la memoria RAM (4GB) e lo spazio di archiviazione (64GB). Google si è molto concentrato sulle fotocamere. Quella principale è da 12 MP e quella frontale da 8 MP. La qualità non sta tanto nell'hardware quanto nei correttivi dell'intelligenza artificiale, che dovrebbe permettere di avere risultati simili ai Pixel 3 anche se a un prezzo più abbordabile.

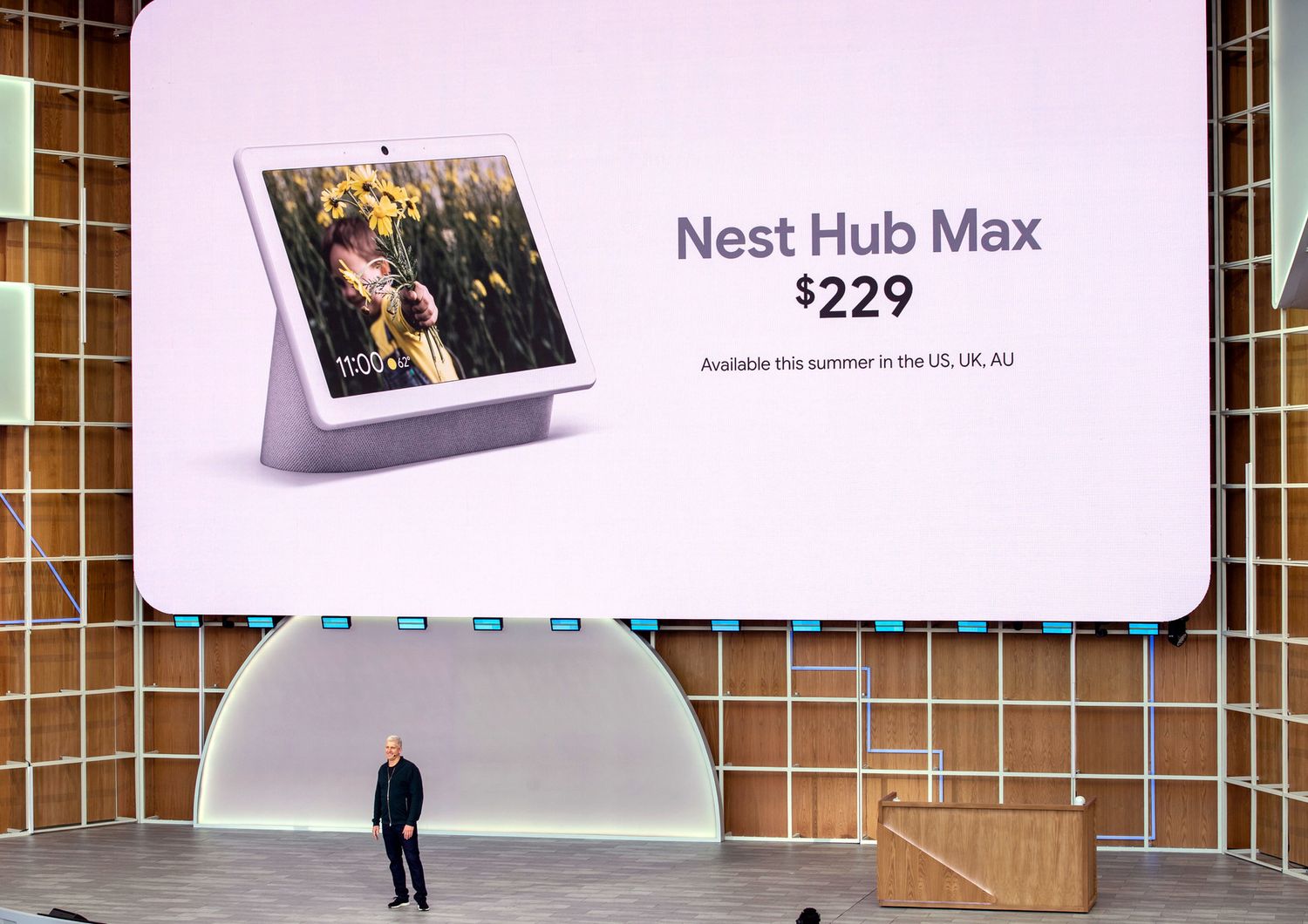

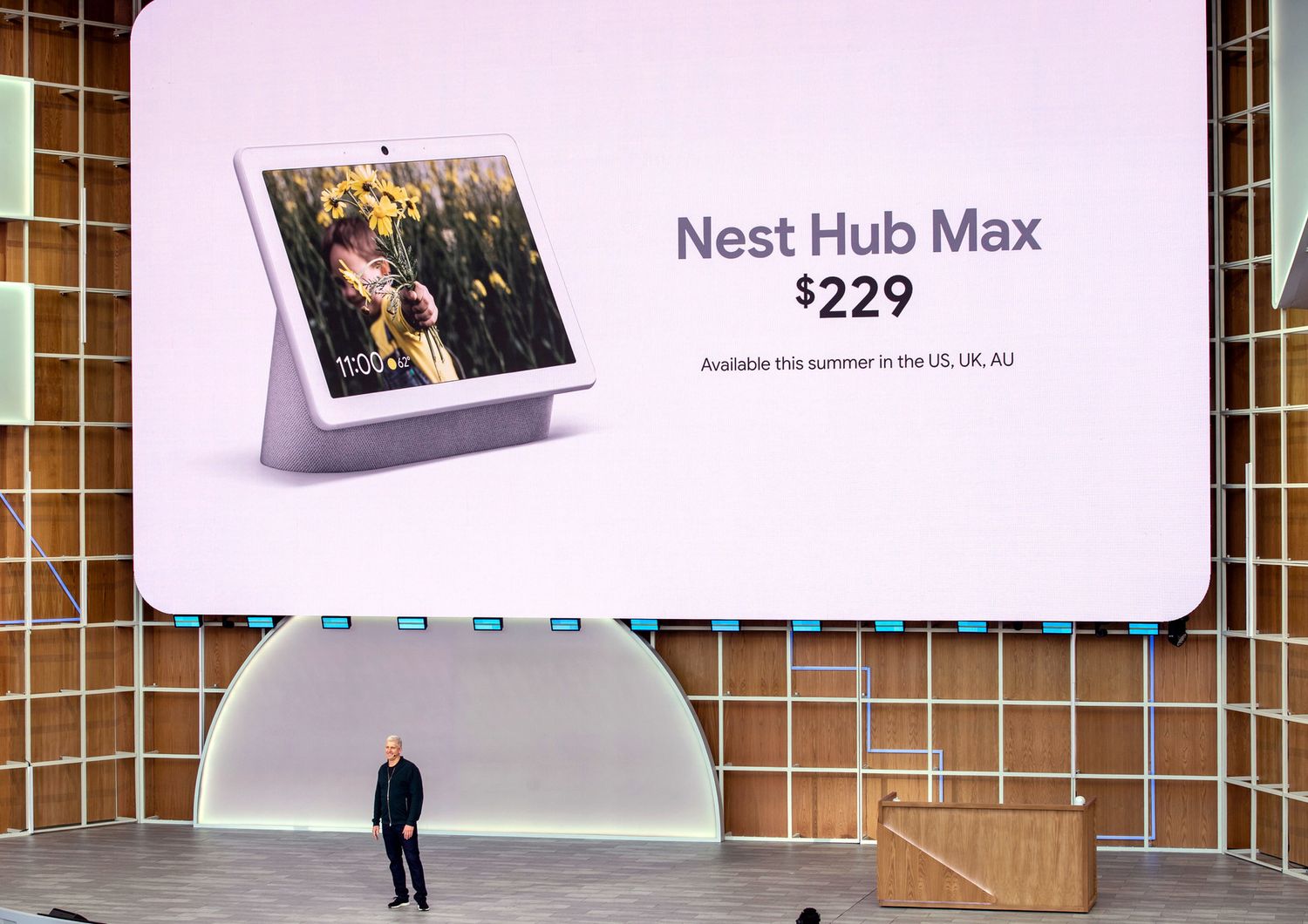

Alla voce hardware, i Pixel 3A non sono stati la sola novità. Google ha presentato Nest Hub Max, il nuovo smart speaker con display. “Nest” è il marchio che Mountain View ha comprato nel 2014 per 3,2 miliardi di dollari. In questi anni ha sviluppato una gamma di oggetti connessi che va dalle videocamere ai termostati. Adesso diventa l'etichetta di tutti i dispositivi rivolti alla smart home, a sottolineare la continuità dell'ambiente domestico. Nest Hub Max è simile al Google Hub presentato lo scorso anno (che cambia nome in Nest Hub, scende di prezzo a 129 dollari e arriva anche in Italia), ma ha nuove funzioni e un display più grande, da 10 pollici. Costa 249 dollari. Oltre alla voce, il dispositivo risponde anche ad alcuni gesti. Ad esempio basterà alzare la mano e rivolgersi verso lo schermo per fermare la musica. Hub Max si propone anche come dispositivo connesso per tenere d'occhio la casa quando l'utente è altrove (è uno degli effetti del rapporto più stretto con gli altri dispositivi della famiglia Nest). Se invece si vuole disattivare l'obiettivo e silenziare il microfono, Google ha introdotto un interruttore fisico, sul retro.

Sul nuovo smart speaker ci sarà Voice Match (che permette di riconoscere la voce del singolo utente per offrirgli un'esperienza personalizzata) ma anche Face Match: stesso obiettivo (calendario, promemoria e contenuti personalizzati, distinti ad esempio tra moglie e marito) ma attraverso i riconoscimento del volto.

Nel corso delle conferenze tecnologiche gli ululati sono un classico. E, diciamo la verità, si sprecano spesso e volentieri per novità che non rivoluzioneranno certo il mondo. Quando però Google ha offerto una dimostrazione del suo “nuovo” assistente digitale, che arriverà in autunno, gli ululati hanno lasciato spazio a un autentico “oooh” di sorpresa. Effettivamente, il test è stato impressionante. Una manager di Google ha parlato al proprio smartphone con un linguaggio del tutto naturale, dando istruzioni una in fila all'altra, rapidamente, senza anteporre ogni volta il comando di attivazione “Ok Google”. Risultato: Google Assistant rispondeva alle istruzioni saltando da un'applicazione all'altra. In una manciata di secondi, ha scritto un messaggio, fatto un preventivo di viaggio su Lyft, selezionato una foto (la manager ha chiesto di cercare le immagini scattate al parco di Yellowstone che ritraevano un animale) e spedito l'immagine.

Secondo Big G, il nuovo assistente digitale è 10 volte più veloce ed è stato “compresso”, occupando così meno spazio sul telefono nonostante prestazioni superiori. L'altro “oooh” è arrivato per un'altra dimostrazione. Ve lo ricordate Duplex? Nella I/O 2018 era stato la star assoluta: l'intelligenza artificiale, praticamente indistinguibile dalla voce umana, chiamava un ristorante e prenotava un tavolo al posto dell'utente. Adesso sarà sempre più integrato con Google Assistant: Big G porta infatti Duplex sul web. Cosa significa? In sostanza è l'intelligenza artificiale a navigare al posto dell'utente, compilando le pagine con le informazioni richieste. La funzione sarà disponibile entro la fine dell'anno negli Stati Uniti e nel Regno Unito, per noleggiare auto e comprare biglietti del cinema. Se l'utente dice “prenota un'auto per il prossimo viaggio”, Duplex attinge dai dati necessari (contenuti nell'account di Google, Gmail, Chrome e Calendario) e li usa per completare la prenotazione. Un segretario digitale nello smartphone, che sa molto di noi e scrive, sceglie, clicca.

So fast, you might've missed it. Running on-device, the next generation Google Assistant makes it easier to multitask across apps—so things like looking up answers, and finding and sharing a photo are faster than ever. #io19 pic.twitter.com/qXwIMbFIz5

— Google (@Google) May 7, 2019

Entro l'anno, Google lancerà la modalità “in incognito” su Maps. Funziona come quella disponibile sui principali browser web: non vengono registrati destinazioni e percorsi. Un'accortezza che arriva dopo le polemiche dei mesi scorsi, legate a una gestione poco trasparente della cronologia delle posizioni. La modalità in incognito arriverà anche su Chrome per mobile e Youtube. Non è solo una questione di riservatezza (sul mio smartphone non resta traccia delle mie destinazioni e dei siti che ho frequentato). Con la modalità in incognito, Google avrà meno dati legati a un account, usati per costruire i suggerimenti delle ricerche (ad esempio la colonna destra dei prossimi video Youtube) ma anche le pubblicità personalizzata che compare in base alla navigazione. Nel corso della conferenza, il ceo di Google Sundar Pichai ha puntato molto sulla privacy, anticipando una nuova sezione dedicata e facilmente raggiungibile: se si sta navigando con il proprio account Google, basterà cliccare sulla foto del profilo per accedervi. La sezione raccoglie le impostazioni in un'unica stanza digitale. L'utente avrà quindi a disposizione alcune opzioni sulla “concessione” dei propri dati e sul tempo limite oltre il quale a Google non è più permesso conservarli.

Android Q è la decima versione del sistema operativo. Numero tondo, che Big G ha voluto festeggiare svelando che il robottino verde è attivo su 2,5 miliardi di dispositivi. Come da tradizione, la I/O ha battezzato la versione beta (provvisoria) del prossimo sistema operativo. Oltre a guardare al 5G, è progettato per supportare il potenziale dei dispositivi pieghevoli: renderà più semplice il multitasking (cioè il lavoro con più app aperte) e permetterà di giocare o scrivere “in continuità” se il dispositivo (come il Galaxy Fold) ha due schermi.

In sostanza, se l'utente ha un'app aperta sul display esterno, non ci sarà alcuna interruzione quando deciderà spiegare lo smartphone per passare a quello interno. Una delle novità che più hanno catturato la platea è stata Live Caption, una funzione pensata soprattutto per i non udenti. È un sistema di trascrizione simultanea, che trasforma in lettere qualsiasi video (compresi quelli girati con il proprio telefono), podcast e file multimediali. Funziona anche senza connessione Internet, perché a trascrivere è l'intelligenza artificiale interna allo smartphone. L'intervallo tra voce e parola scritta è praticamente nullo. Android Q avrà una sezione dedicata alla privacy più chiara. E una dedicata alla gestione della geo-localizzazione.

Tra le altre cose, l'utente riceverà una notifica quando un'app in background (attiva, ma non usata in quel momento) sta utilizzando la sua posizione e potrà decidere se continuare o meno a condividerla. Il sistema operativo amplia le funzioni che permettono di controllare il tempo trascorso sul telefono. Ci sarà una modalità “Dark” (con sfondi scuri, per ragioni estetiche ma anche per risparmiare la batteria) e “Focus”: se attivata consente di disabilitare le applicazioni che distraggono. Stai studiando e vuoi evitare Instagram e Facebook ma mantenere attivo Whatsapp? Bastano un paio di mosse, senza silenziare le app una per una né bloccarle tutte. Aumentano le opzioni per i genitori che vogliano imporre vincoli ai figli: su Android Q si potrà impostare un tempo limite per ogni applicazione.

Google interviene sui suoi risultati di ricerca: quando si cercheranno informazioni o termini, sarà disponibile l'opzione “Copertura completa”. È una possibilità già presente su Google News: raccoglie gli articoli in primo piano, i video su quella notizia e la cronologia degli aggiornamenti. Tra i risultati ci saranno anche i podcast e le animazioni in 3D. L'utente sta cercando informazioni sull'apparato scheletrico? Google metterà a disposizione uno scheletro in tre dimensioni, che grazie alla realtà aumentata può essere “posizionato” sulla propria scrivania. Stesso discorso per gli articoli d'abbigliamento: se cerco le scarpe di una marca, avrò a disposizione un'animazione tridimensionale per osservarle da ogni angolazione e – puntando il telefono - vedere come potrebbero calzare ai miei piedi.

Questa non è una funzione che vedremo su Android, non subito almeno. Ma il progetto Euphonia, presentato sul palco da Google, è una di quelle applicazioni “buone” dell'intelligenza artificiale. Il riconoscimento vocale, grazie al quale noi parliamo e i dispositivi scrivono o ci rispondono, sta ormai entrando nell'alveo della normalità, facendoci dimenticare che dietro c'è una tecnologia estremamente complessa: un software deve conoscere il significato delle parole, capire modi di dire, comprendere i suoni in lingue e accenti diversi. Il progetto Euphonia prova a fare la stessa cosa, provando però a “tradurre” piccoli cenni, versi, pronunce distorte. Sarebbe un aiuto per chi ha subito un ictus, malati di Sla, sclerosi multipla o Parkinson. In sostanza, l'obiettivo è fare quello che fanno i programmi di trascrizione automatica. Ma partendo da un'altra “materia prima”.

Uno dei casi presentati da Google è quello di Dimitri Kanevsky, un ricercatore di Mountain View: nato in Russia, ha imparato l'inglese dopo essere diventato sordo da bambino. Il suo lessico è impeccabile, la sua pronuncia difficoltosa. Google ha sviluppato un sistema di trascrizione in tempo reale personalizzato. L'intelligenza artificiale conosce la “lingua” di Dimitri e la trasferisce sul display di uno smartphone in inglese corretto. Steve Saling è affetto da Sla e non riesce più a parlare. Euphonia ha tradotto minimi cenni del volto in risposte verbali e suoni (sì, no, esultanza o disappunto) che rendono più immediate le reazioni rispetto alla tastiera che “clicca” con gli occhi. In altri casi di Sla, i ricercatori hanno tradotto dei mugolii in comandi per accedere e spegnere la luce o attivare dispositivi.